AI蓝皮书:Gemini反代教程,免费API调用Gemini 3 pro模型(兼容酒馆/Chatbox)

AI本地布置&远端调用系列教程

[展开/折叠]-

从零开始了解本地AI部署

Ollama本地部署AI教程

-

盘点支持免费API调用的AI服务

远程接入API教程(Gemini/NVIDA/ModelScope/Hugging Face)

-

Gemini反代教程

支持免费接入酒馆/CHATBOX等应用

-

Docker&New-API搭建教程

整合不同的AI,创建自己的轮询API

Google AI/Gemini终于出3.0版本了!但是3.0版本当前仅允许在官方页面上免费试用,任何第三方API调用都要付费。虽然网页版给的很大方(100次/天),但是确实有很多应用第三方调用体验会更好。为了解决这个问题,BLOG主今天教大家如何通过反代(劫持网页端)的方式,让第三方软件也能免费调用GOOGLE最新的Gemini 3 pro模型!

PS:本教程整合自类脑多位大大的成果,原始教程参考的是这篇,已经集成了“𝓟𝓻𝓲𝓼𝓸𝓷𝓮𝓻”大佬提供的最新版本,安全性和稳定性都得到过验证。

SillyTavern(酒馆/AI猫娘)系列

[展开/折叠]-

SillyTavern(酒馆)从入门到精通

喂饭式教学,不可能学不会

-

手机(Android)安装布置教程

随时随地逗逗猫娘的方法

-

免费VPS服务器租用和布置教程

通过第三方服务器开设酒馆教程

-

各种技巧/插件的说明

玩酒馆必看的进阶教程

-

GPT-SoVITS文本转语音入门教程(含SillyTavern酒馆接入)

AI语音合成,提升沉浸感的好方法

-

酒馆本地跑文字模型测试和推荐

当前还不太行的本地模型测评

-

盘点支持免费API调用的AI服务

需要免费接入酒馆的AI,来看这里吧

-

Gemini反代,免费API调用Gemini 3 pro模型

当前酒馆免费接入的AI中效果最好的选择!

一、搭建Huggingface服务

我们首先需要使用Huggingface搭建一个反代服务器,架设一个从Google AI到终端服务(比如酒馆/chatbox)的桥梁。

1、打开官网,点击右上角Sign Up按钮,按照要求填写邮箱和密码(如果打不开网站,你应该需要梯子)。注册完成后,记住去邮箱点击验证链接,否则后面会无法继续操作。

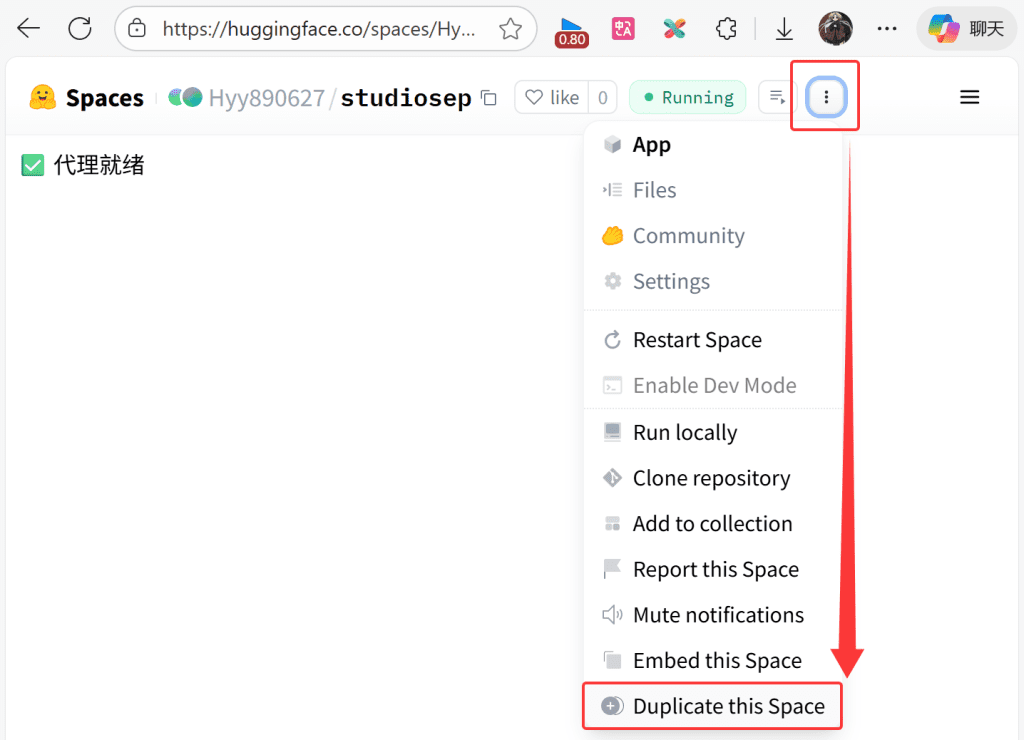

2、接着打开BLOG主建立的这个仓库地址,点击上方右侧的三个点,在展开菜单中,选择“Duplicate this Space”,将会复制BLOG主这个仓库的内容到你自己的账号上。

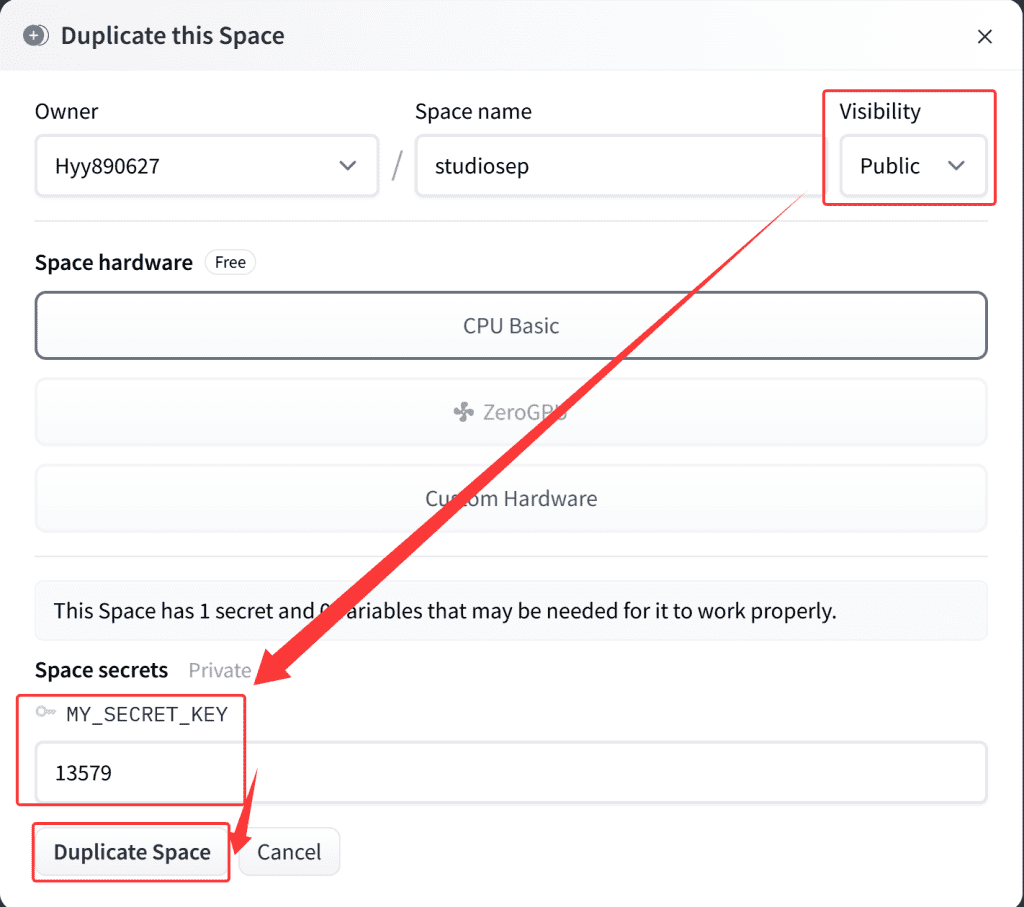

3、在弹出的对话框中,Visibility中选择Public,确保服务器能被公网检索。然后下面的MY_SECRET_KEY是连接这个代理服务器的密码(展示密码为13579,第三方接入,这个密码是必须的),这里建议自己设置的复杂一些,以免出现安全风险。最后点击Duplicate Space,完成全部设置。

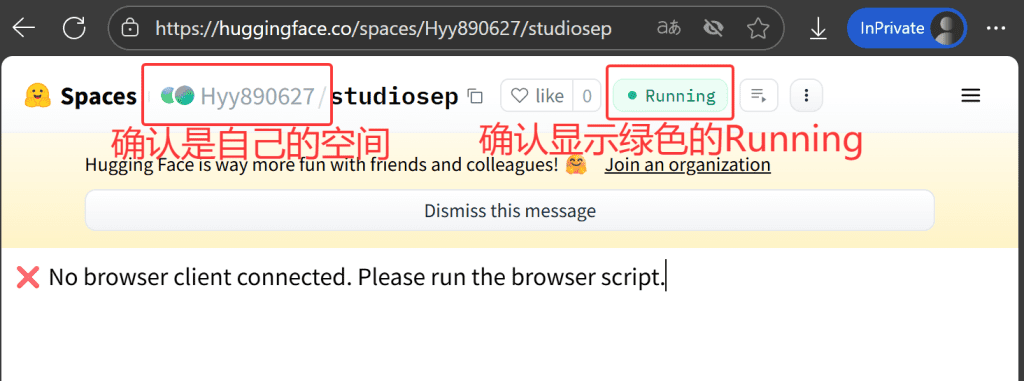

4、等待约1分钟,随后根据下图,确保这个新建的服务属于自己,确保服务已经正确运行。

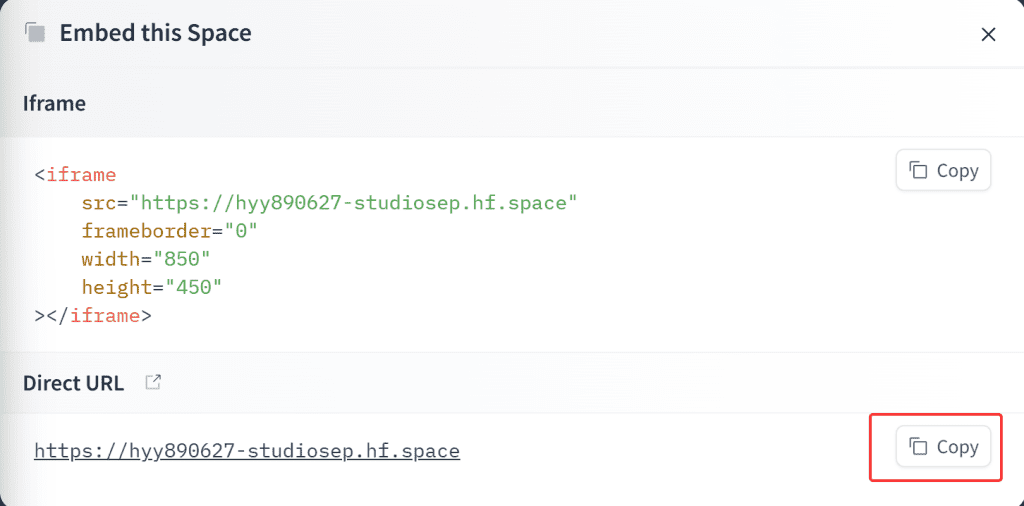

5、然后再次点击上面的三个点,选择“Embed this Space”,随后在打开的窗口中,点击“Direct URL”右面的“Copy”按钮,这样就会在剪贴板中获得该服务的API接口地址(建议找个地方保存)。

6、保持这个网页开启,不能关闭!!不能关闭!!不能关闭!!

二、浏览器部分

1、类脑的大佬对服务部分做了更新,建议下载最新版本的“dark-browser-vps.js”(最新服务端dark-server-vps.js已经整合)。由于不同版本的内容需要对应,因此建议直接点击这里下载BLOG主整理好的文件。

扩展内容:更新服务器

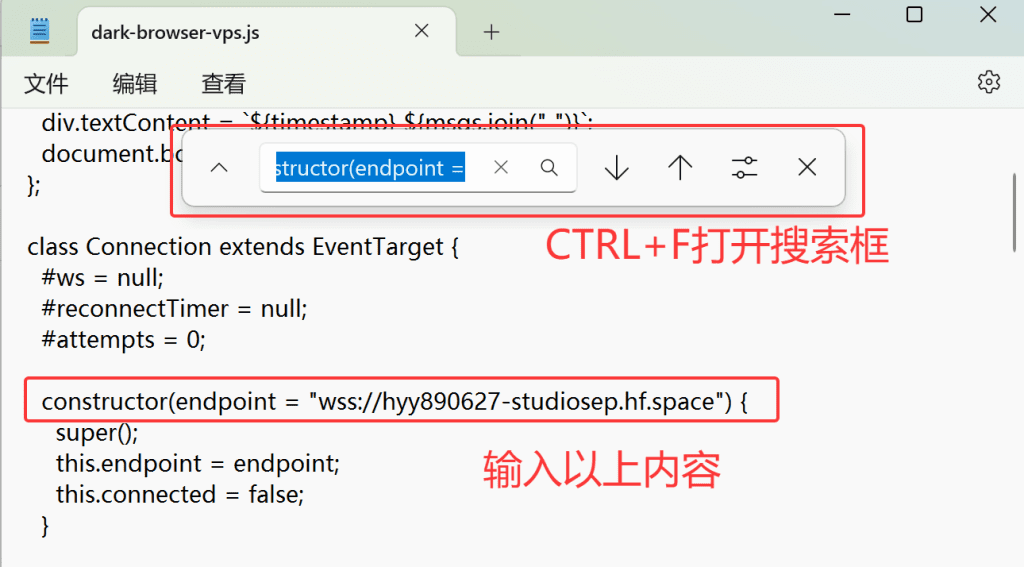

[展开/折叠]2、接下来我们需要修改“dark-browser-vps.js”的一些配置,右键这个文件,选择笔记本打开,然后“CTRL+F”搜索“constructor(endpoint =”。最后在后面添加刚刚复制好的API接口地址。注意需要把原始地址中的“https”改成“wss”。

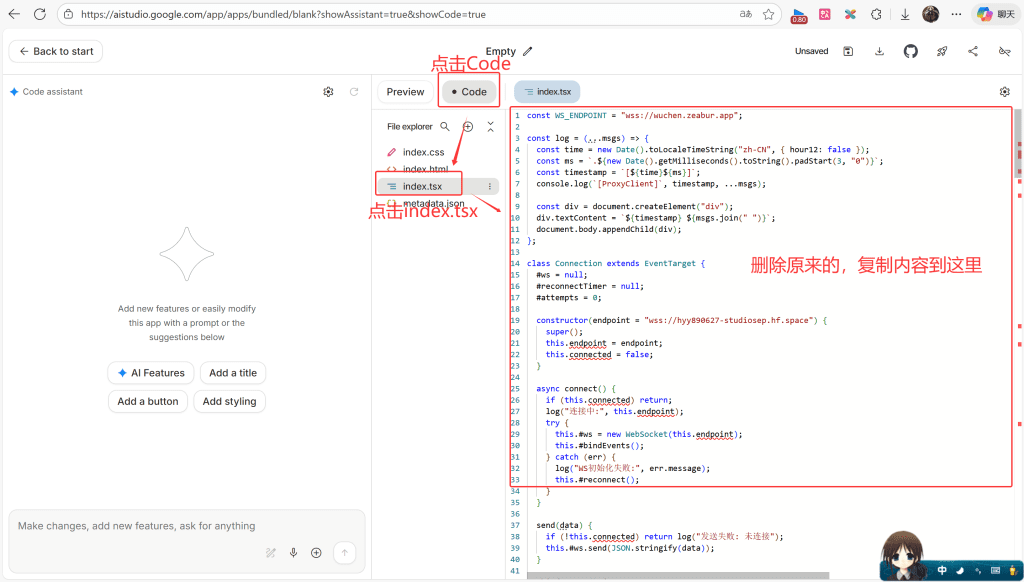

3、打开这个链接,登录自己的GOOGLE账号(建议新注册一个,需要梯子、不建议用大号)。在打开的页面中,点击“Code”,然后点击“index.tsx”,最后将上一步修改好的“dark-browser-vps.js”(或者直接复制修改好的上述代码)中所有内容,复制到右面的框中。

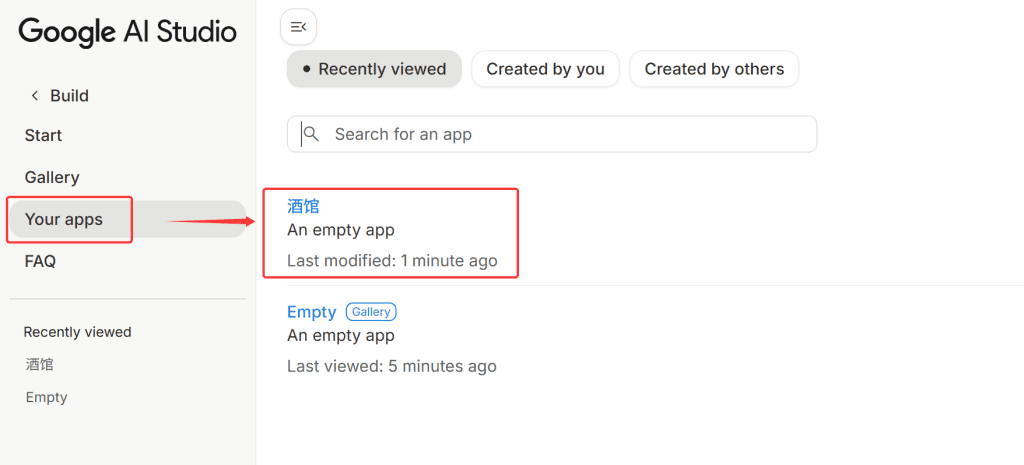

4、记住保存一下这个配置,点击右上角的保存图标,重新命名之后就可以保存(比如BLOG主保存名字是“酒馆”)。下一次使用的时候,我们只需要在GOOGLE AI主页,点击“Your apps”,然后选择刚刚保存的“酒馆”就可以再次载入,而无需再执行一次第三步。

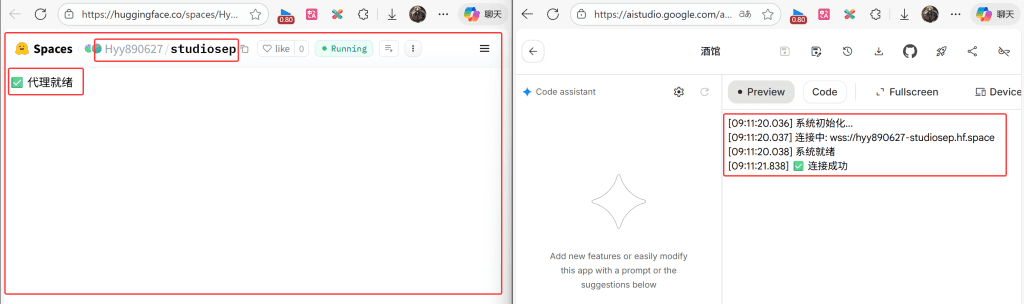

5、我们回到“Preview”页面,正常来说等待几秒,看到绿色的“连接成功”标志,即代表GOOGLE AI已经正常工作。

6、我们再次观察浏览器,当前你的浏览器必须同时开启“Huggingface”和“Google AI”两个页面(只要使用服务就必须开启)。各位可以对照下图,再次确认是否左右两个网站都标注为绿色的“代理就绪”和绿色的“连接成功”,查看左右两边是否都是自己项目的名字。如果与下图一致,那么恭喜你,反代已经完成。

三、服务调用(范例)

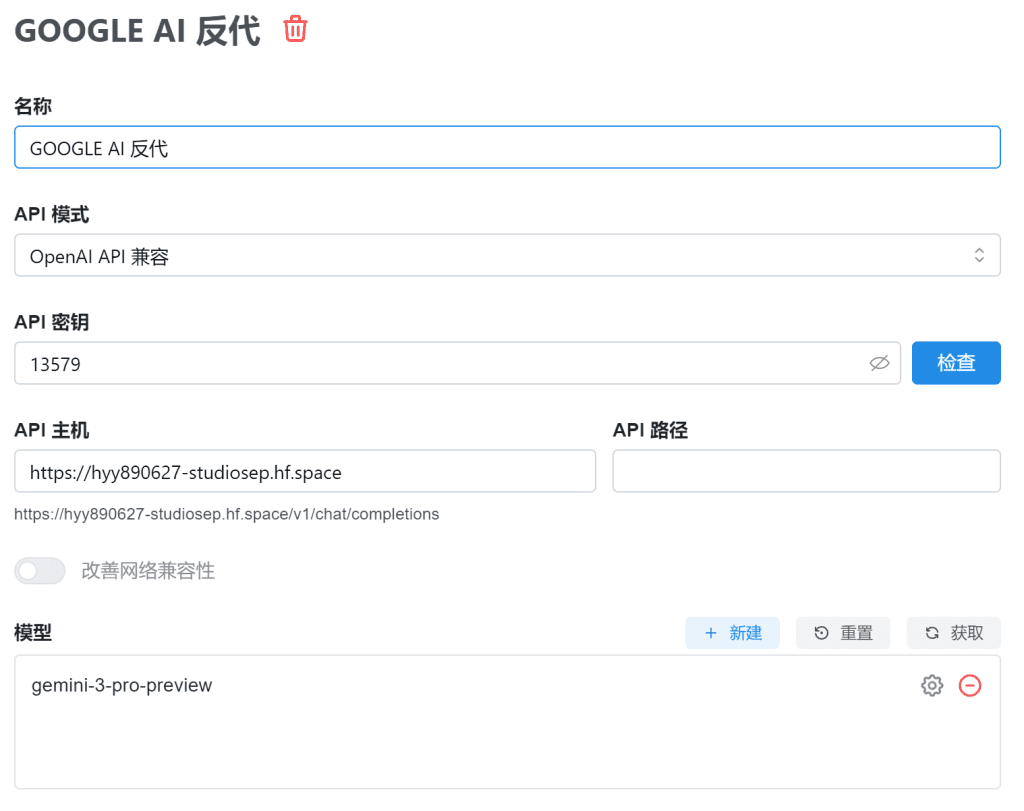

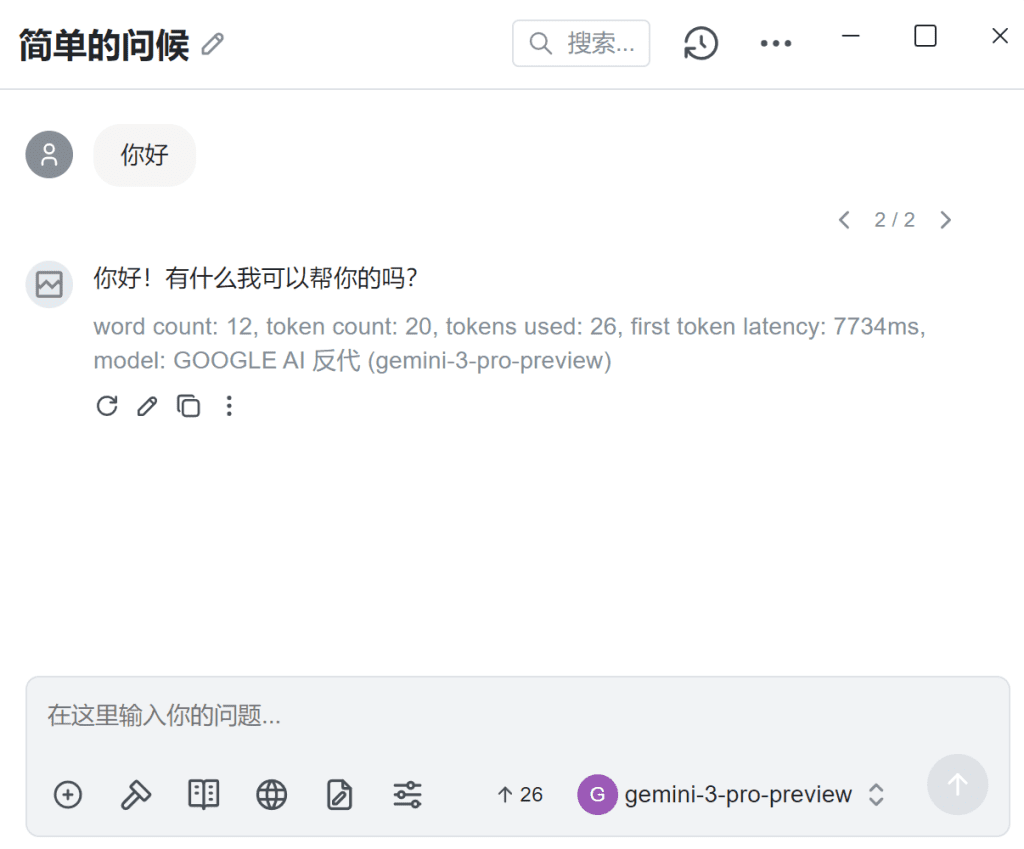

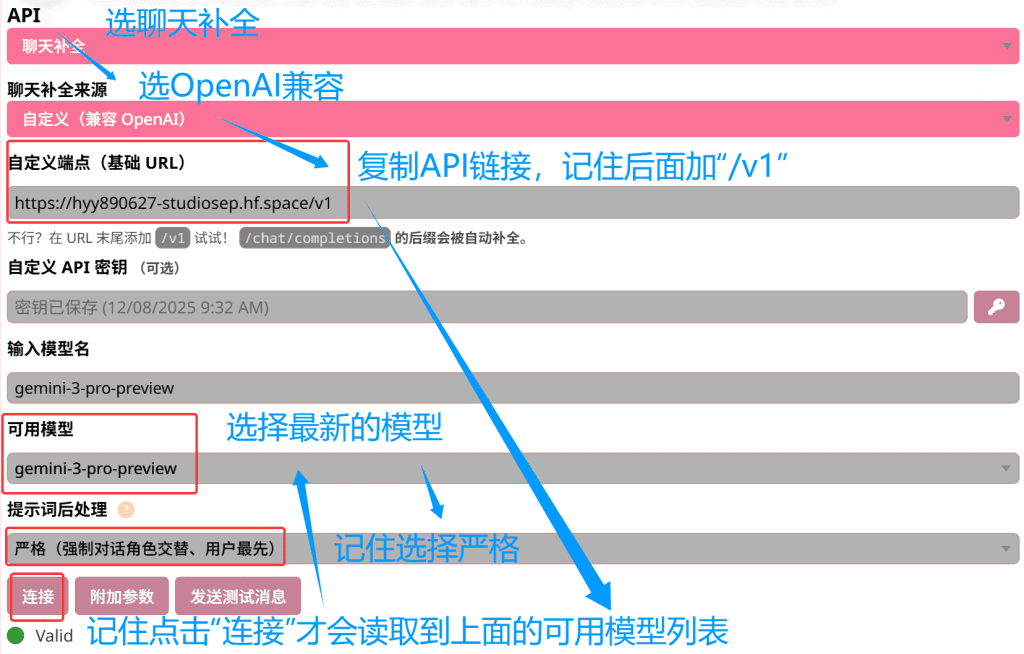

1、以chatbox为例

添加“OpneAI API 兼容”页面,在下面填上Huggingface服务中生成的API链接以及刚刚自己设置的连接密码(如下图所示),然后点击右下角“获取”,即可得到当下支持的模型,这里选择最新的“gemini-3-pro-preview”。

回到主页面,选择好对应的模型,即可安心的使用。(反代当前有100次/天的使用限制,如果超过该数量,建议重复上面全部操作(包括注册新的GOOGLE账号),做多一个API/KEY供使用。另外也可以根据BLOG主以前的NEW-API教程做API轮询)

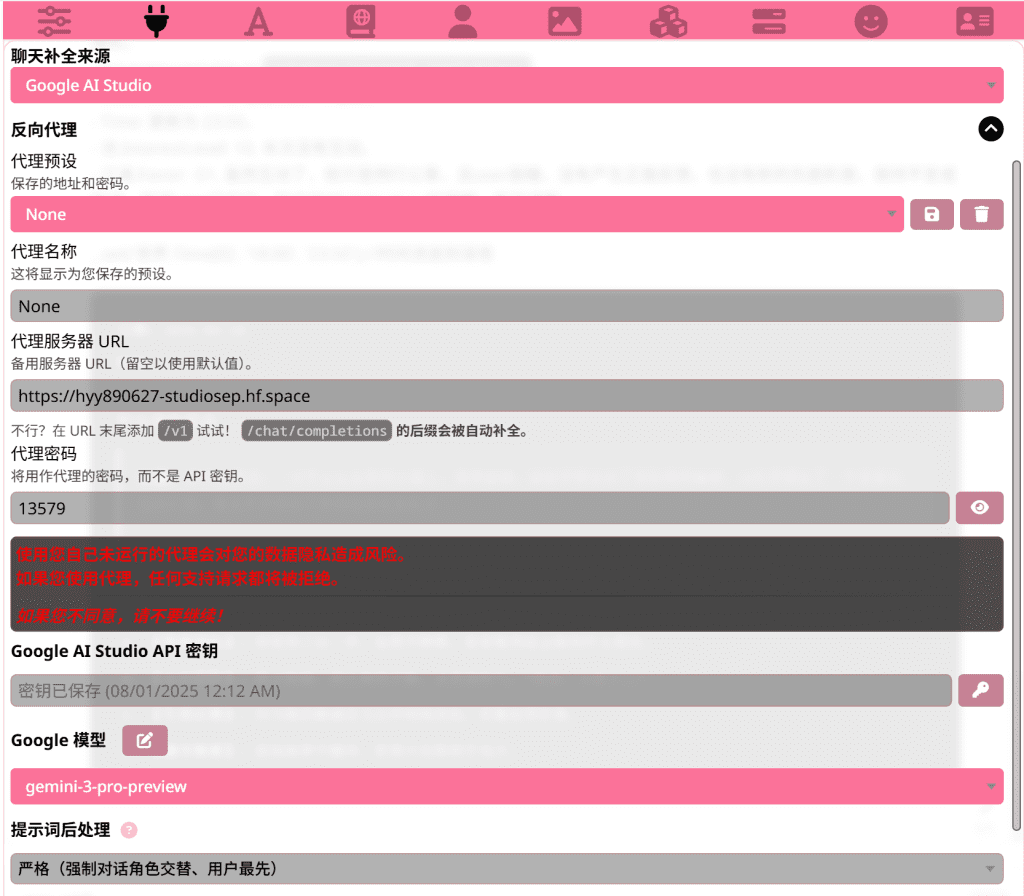

2、以酒馆(SillyTavern)为例

打开酒馆API设置页面,按照下图进行设置。

如果OpenAI兼容有问题,可以选择使用Google AI Studio进行反代设置,跟着下图设置就行,理论上直接设置反代会比使用openai格式好一些。

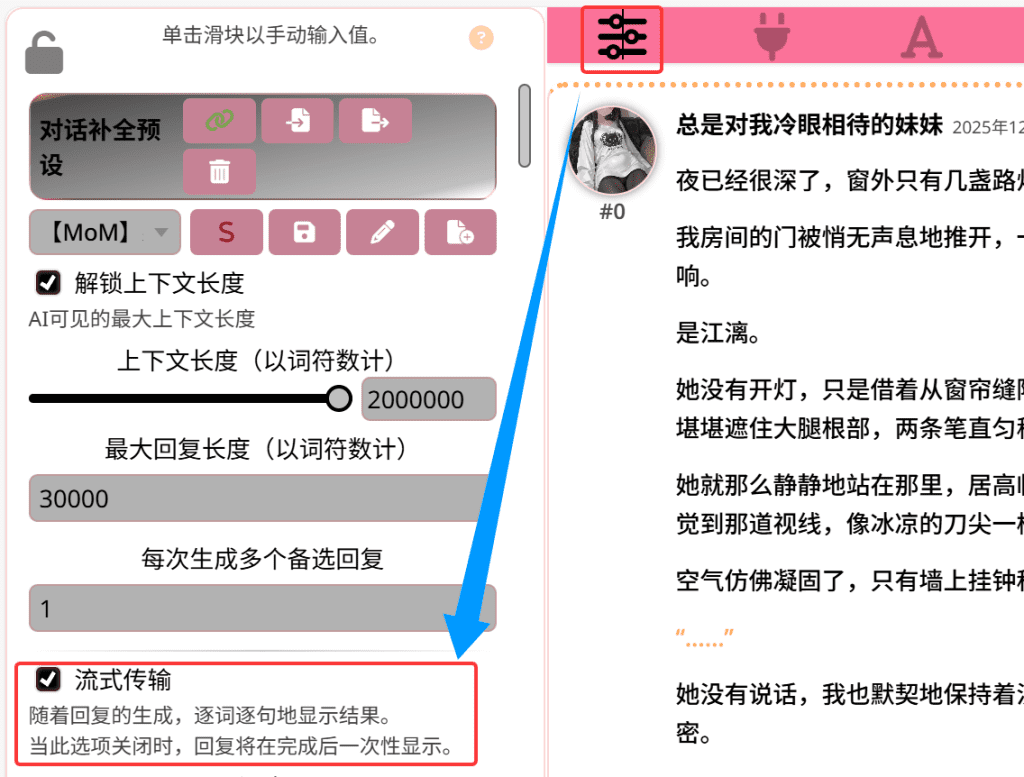

完成API设置后,就可以愉快的免费使用Gemini 3.0逗猫娘了!对了,记住把预设中的“流式传输”打开才能正常输出哦。(经过测试,不开流式更好25.12.19更新)

44条评论

sink

666大佬

V

谢谢你,对纯小白帮助很大,但是还有几个疑问,

文章中说的【反代当前有100次/天的使用限制,如果超过该数量,建议重复上面全部操作,做多一个API/KEY供使用】,重复全部操作指的是从注册新的谷歌账号开始吗,我拿同一账号搞了2个好像不行。

gemini pro会员跟这个是不是没啥关系,我搞了个会员好像也不会加API额度

huoyanyan

是的,限制是对GOOGLE账号的,所以需要从账号申请开始,全部操作都做一次。好像是的,gemini pro并没有提供更多的免费额度。

V

哇回这么快,谢谢谢谢,了解了,我研究了3天了,这是我找到的最细致最清晰的攻略,没想到还会回评论,伟大!

mzq

佬,连接好之后 输入时提示API returned an error

Unauthorized这是啥情况 我开的3.0反代成这个样子了

huoyanyan

确认一下账号有没有被BAN了?

TTT

好奇怪啊,总是输出几十个字就断了,

收到请求: POST /v1beta/models/gemini-3-pro-preview:streamGenerateContent (real)

[23:24:34.819] 执行请求 (1/3): POST /v1beta/models/gemini-3-pro-preview:streamGenerateContent

[23:24:49.631] 流读取完成

[23:24:49.631] 🤔 响应异常: PROHIBITED_CONTENT

[23:24:49.632] 任务完成

huoyanyan

我最近也遇到了,你试试把流式关闭

TTT

后来发现好像是角色卡的原因,不能玩未成年的卡,aistudio网页逆向的api容易截断和空回。所以我后来换了其他discord上面的公益站api,这种api好像是用cli逆向出来的,和网页逆向不一样,啥角色卡都能玩,感觉跟谷歌原生api没区别

111

bozhu 两个页面使用时必须要打开吗

huoyanyan

是我没写中文吗?

111

不写中文更看不懂了。(doge

111

梯子节点一定要某些特定区域的才能用吗

huoyanyan

是的,当前GEMINI只能美国、日本、新加坡之类的才能用,香港是不能用的

felain

bozhu,huggingface里显示无连接而非代理就绪是什么情况

huoyanyan

同时打开GOOGLE AI了么

banana

huggingface里显示无连接而非代理就绪,我也是这个情况,仔细检查了每一步应该没有出错的,ai sdutio和huggingface也是同事打开的

huoyanyan

加群吧,这样说不明白

chen yang

我也是这个问题,一步步做下来的,所以preview是提示,请问加什么群,谢谢

Build

Render Start

Build

Render End

Error

“Uncaught SyntaxError: Illegal return statement”

huoyanyan

群号在最上面。

wwxphxx

谢谢大佬,想问下这个api能在VideoCaptioner这种软件里面调用吗

huoyanyan

没用过,不知道,自己试

123

大佬的教学受用,简单且已经成功,这是唯一可以在非原生接口用Gemini 3 Pro preview的最好方法 (不花钱不能用Gemini3Pro的API)

我才第一次用酒馆就看到大佬这篇,要是没看到我现在还是得卡在aistudio的页面才能用Gemini 3 Pro,感谢大佬

解锁上下文长度和最大回復长度要改,改得像大佬的画面就可以了,没改AI会说不了话

流式开不开没差,我现在都没开,反而不开比较不会说一半断掉,我没少让AI说些禁句但都可以过

dark-server-vps.js修改一下可以让多个Google账号共用同一个Huggingface反代服务器,我是叫Gemini3直接帮我改了

效果很不错,免费仔可以用多个账号当电池库,我用九个Google账号,遇到quota满了就让它下线,这些功能叫Gemini3 Pro帮忙改了就行

总之就是感谢huoyanyan大佬,让我无痛从aistudio转战酒馆,还可以继续用最新模型Gemini 3 Pro preview,这篇教学必须收藏

huoyanyan

感谢支持~BLOG里面还有很多实用的教程=W=

夜夜不会受伤

万分感谢,我说ai怎么只会回?,照着日志找问题,弄了几天也还没弄出来,没看到你这条,我还真可能弄不出来,同时也在这感谢一下HUOYANYAN大佬ヾ(´∀`。ヾ),好人一生平安,真的万分感谢

Torose

天哪博主太强了 喂到嘴边的饭太香了 祝你长命百岁永远不死

huoyanyan

总感觉怪怪的233你们喜欢就行

司雨觋

首先很感谢,然后倒在卡梯子地区(香港)无法使用服务,加上最近的一些事让我力竭了,总之这篇文章还是很不错的,谢谢。(没搞成让我很愤怒以至于停止道观直到死亡)

huoyanyan

换个梯子咯……

my489926

大佬,现在Get code选哪个啊?

huoyanyan

Get什么?什么code?

夜夜不会受伤

佬,模型只会回复?是什么问题

这是日志

Applying custom prompt post-processing of type strict

Chat Completion request: {

messages: [ { role: ‘user’, content: ‘Hi’ } ],

prompt: undefined,

model: ‘gemini-3-pro-preview’,

temperature: 1,

max_tokens: 300,

max_completion_tokens: undefined,

stream: false,

presence_penalty: 0,

frequency_penalty: 0,

top_p: 1,

top_k: undefined,

stop: undefined,

logit_bias: undefined,

seed: undefined,

n: undefined,

logprobs: undefined,

top_logprobs: undefined

}

Chat Completion response: {

id: ‘chatcmpl-1766721645537_a3gkwl0ue’,

object: ‘chat.completion’,

created: 1766721645,

model: ‘gpt-4’,

choices: [

{

index: 0,

message: {

role: ‘assistant’,

content: ‘Hello! How can I help you today?’

},

finish_reason: ‘stop’

}

]

}

自己也跟着ai弄了几天了,实在没招了,也不懂,请教一下

huoyanyan

是不是已经解决了?

夜夜不会受伤

对是的,这个评论你可以删除了,评论区里有其他人说了这个问题,感谢大佬回复以及分享,真的十分感谢(*σ´∀`)σ

夜夜不会受伤

对是的,这个评论你可以删除了,评论区里有其他人说了这个问题,感谢大佬回复以及分享,真的十分感谢(*σ´∀`)σ,

李田所

请问以下可以用于cline吗?我这边部署成功后在chatbox填入是可以正常对话的,但是不知道为什么在vscode里的cline中填好配置后执行却无法正常对话,一旦发送请求,aistudio这边就会显示报错信息

huoyanyan

没用过cline,问我不如问AI

李田所

问题解决了,原因是cline对google gemini api的兼容性问题,我修改了一下tsx的一些配置就能正常通信了

yygtyhl

大佬,我新注册的账号和反代,在gemini和Google ai里都能正常说话,但ai在酒馆里输出一直是长度2t的空内容 什么都没有,api连接是成功的,aistudio里显示这样的

[21:37:15.894] 收到请求: POST /v1beta/models/gemini-3-pro-preview:streamGenerateContent (real)

[21:37:15.898] 执行请求 (1/3): POST /v1beta/models/gemini-3-pro-preview:streamGenerateContent

[21:37:23.585] 流读取完成

[21:37:23.585] 🤔 响应异常: MAX_TOKENS

[21:37:23.585] 任务完成

这是token用完了吗怎么会这样

yygtyhl

已经解决了大佬,他一句话回了我400t的内容,我原来设置最大回复长度只有300

我该怎么让他一次回复少一点呢?在角色卡里加设定吗?我在酒馆设置里设置过小的限度好像就会报错了

huoyanyan

在预设里面改

wizard

大佬是否这种方式必须要浏览器页面,我在大家的网站后端想用build是不是比较难

maken

大佬429 – Your account email address needs to be confirmed before you can perform this action.这个怎么办

huoyanyan

你的账户邮箱地址需要确认后才能执行此操作