AI蓝皮书:为Ollama添加AMD显卡支持

当前Windows系统上Ollama虽然已经支持了AMD的ROCm框架,但是仍然有部分AMD显卡并未能受到支持(比如最新的90系)。虽然苏妈已经声明很快就会让ROCm架构覆盖完整WIN系统,但为了让新买的显卡第一时间享受到AI带来的快乐,下面就跟着BLOG主做吧。

1、安装Ollama

这一步非常简单,BLOG主之前写过相关教程,跳转去看就好了,顺便了解AI的基础知识。

2、查询自己的显卡是否受到支持

在Ollama官网上,已经公示了受到支持的AMD显卡,如果你的型号在上面,那么无需额外的操作,根据BLOG主的Ollama教程,添加想要运行的模型就可以运作了。

3、添加未受支持显卡的ROCm

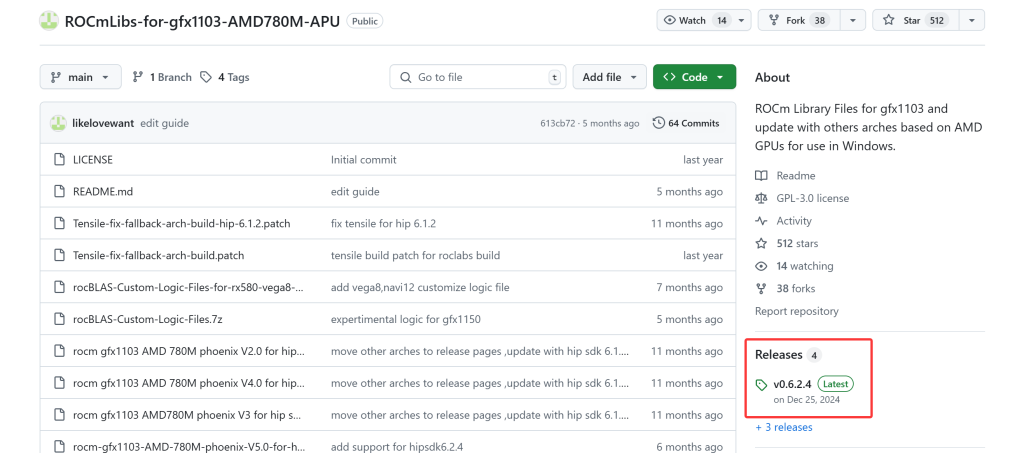

如果你的显卡未受支持,那么就可以打开这个Github项目,然后点击右面的“Releases”的最新更新版本“Latest”(随着时间推移,这个版本会不断更新,下图仅供参考)

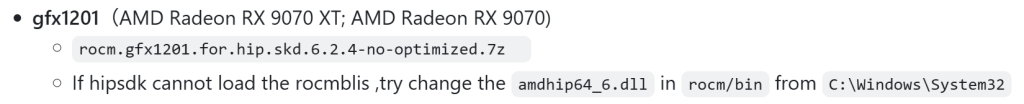

查询自己显卡的gfx编号,这里最简单的方法就是直接在Google上搜索自己的显卡型号+rocm/gfx,如果未来有更简单的方法,BLOG主也会更新。由于当前绝大多数的情况应该都是90系新卡未受支持,因此直接查阅Github上的介绍,就可以得知RX 9070XT和RX 9070的gfx编号为1201。

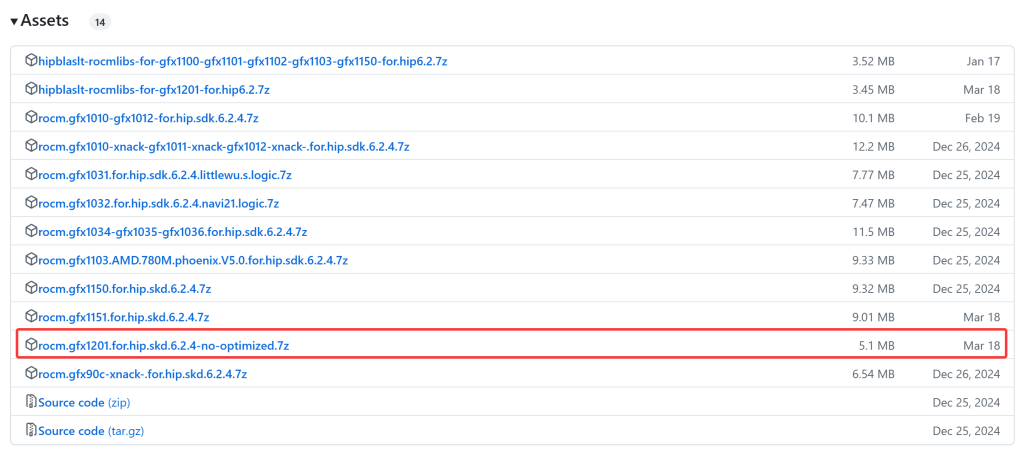

然后滚动到下面,在Assets上找到gfx1201的rocm包,下载并解压缩即可。

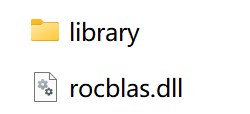

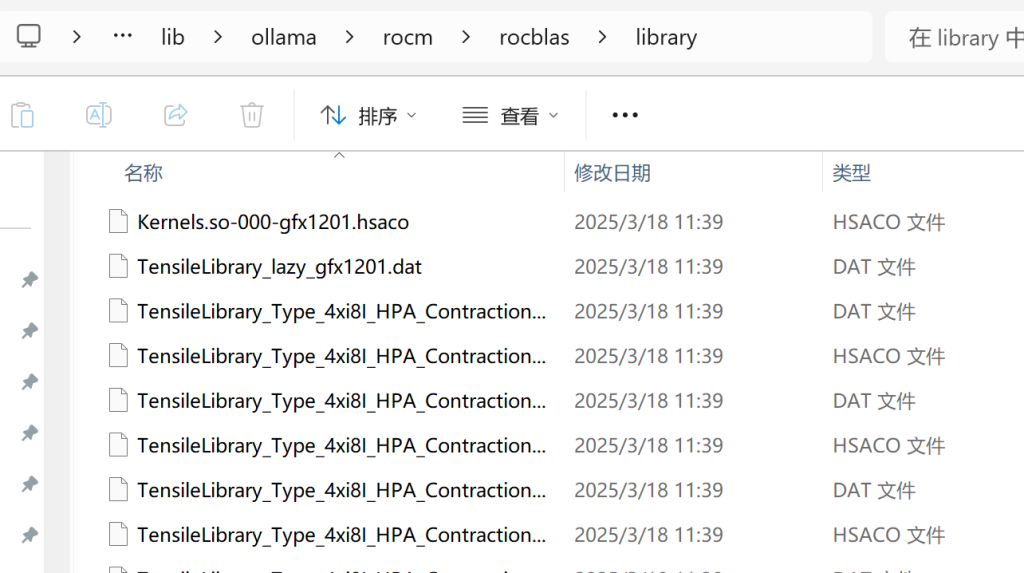

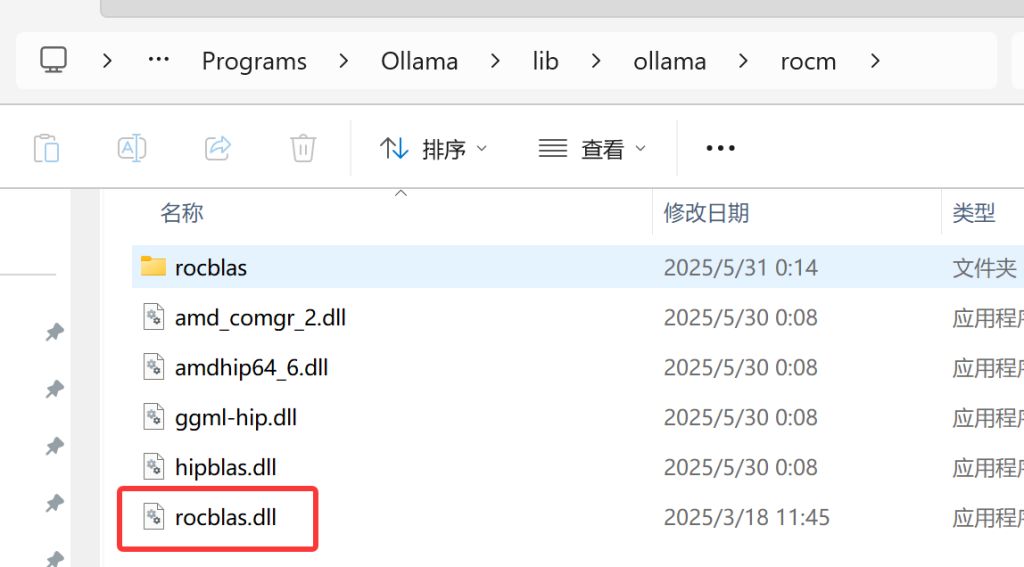

解压缩完毕后,我们会得到以下两个东西:一个名为“library”的文件夹,和一个“rocblas.dll”的文件。

接下来,我们需要将“library”文件,复制到下面路径上(注意你的用户名需要自己替换进去,不要直接使用)

C:\Users\你的用户名\AppData\Local\Programs\Ollama\lib\ollama\rocm\rocblas\library

然后将“rocblas.dll”文件覆盖下面路径的同名文件。

C:\Users\okhuo\AppData\Local\Programs\Ollama\lib\ollama\rocm

接着,我们重启Ollama主程序,即可完成对自己显卡的支持。再次运行大模型,就可以看到GPU占用跑上去了。